Negros e asiáticos são presos injustamente com frequência por conta de erros nos algoritmos.

Uma análise dos softwares, realizada pelo NIST (National Institute of Standards and Technology) identificou uma diferença entre 10 a 100 vezes mais de falsos positivos em fotos de negros e asiáticos em comparação com brancos.

Há um movimento internacional que reinvindica o banimento do reconhecimento facial, tecnologia impregnada com inúmeros vieses que reforçam o racismo e a discriminação de diversas formas. Muitas vezes, um rosto é confundido com outro e o erro pode acontecer em diferentes etapas: na coleta dos dados, no processamento, no resultado e também na análise das informações.

Casos em que os erros dos softwares de reconhecimento facial prendam pessoas negras injustamente são bastante comuns, em Detroit, no ano passado, dois homens negros foram presos equivocadamente por falhas nesse sistema.

Uma pesquisa do NIST (National Institute of Standards and Technology), depois de analiasar 189 programas de reconhecimento facial criados por 99 desenvolvedores, constatou um maior número de falsos positivos em fotos de negros e asiáticos em comparação com brancos, numa diferença que variou de 10 a cem vezes mais.

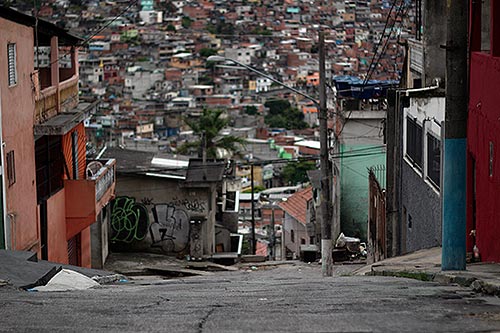

O mapeamento 3D com tecnologia blockchain que está sendo realizado na favela da Rocinha, no Rio, também gera preocupações sobre a privacidade de dados dos moradores. “O debate sobre segurança não furou a bolha para chegar na favela, aí vemos casos como esses acontecendo”, afirma Nina Da Hora, cientista da computação e complementa no Brasil, falta transparência na coleta de dados .

No final de abril, a Central Única das Favelas (Cufa) suspendeu um mecanismo de reconhecimento facial que permitia cadastrar pessoas em um programa de doação de cestas básicas. Depois do questionamento de Nina e outros especialistas no assunto nas redes sociais, o presidente da entidade, Preto Zezé, comunicou a decisão de interromper o uso da tecnologia. Em seu perfil no Twitter, ele escreveu: “tudo cancelado. Inclusive, gerou um bom debate sobre segurança de dados”.

“O Brasil é um dos países com a maior base de dados disponíveis, mas falta transparência na coleta e falta segurança”. É no debate que está a solução para o uso indevido tanto do reconhecimento facial, quanto de outras tecnologias de inteligência artificial que reforçam o racismo. As empresas, por sua vez, tratam o algoritmo como parte do negócio, mas não dão acesso aos processos de como isso é feito.

“Se a gente [cientistas e pesquisadores] soubesse de que maneira um algoritmo de uma rede social prejudica alguém, poderíamos desenvolver fases de pesquisas para combater o problema, mas muitos estudos ficam com as Big Techs”, pontua Nina.

Em abril do ano passado a Netflix lançou o documentário Coded Bias para assinantes brasileiros, que explica como funcionam os vieses nos algoritmos. O ponto de partida do filme foi um experimento realizado pela própria diretora, Joy Buolamwini, cientista da computação e ativista digital, que testou um software de reconhecimento facial por meses a fio: a máquina não a reconhecia, mas quando ela punha uma máscara branca, o software assimilava o reconhecimento.

“Hoje, minhas referências no assunto são mulheres negras, em sua maioria dos EUA”, conta Nina, citando, além de Joy Buolamwini, Abeba Birhane, Rediet Abebe, Deborah Raji e Timnit Gebru, que saiu do cargo de co-lead do time de ethical AI do Google no final de 2020, depois de ter elaborado uma pesquisa sobre os impactos do deep learning no meio ambiente. Ela também é coautora de um paper que comprova como o reconhecimento facial é menos preciso na identificação de mulheres e pessoas negras, além de ser uma das fundadoras do grupo Black in AI.

No Brasil, jovens cientistas e pesquisadoras — como a própria Nina Da Hora, 25 anos e recém formada em Ciência da Computação pela PUC-RJ — despontam como questionadores dos processos muitas vezes obscuros dos algoritmos e da IA, buscando mais transparência, diversidade e esclarecimentos para a sociedade civil.